探索生成式 AI 的潜力与风险

关键要点

生成式 AI 技术具有创建真实且新颖内容的能力,包括图像、文本、音频和视频,它将极大地促进企业的创造力和生产力。然而,该技术也带来了网络安全和数据隐私的风险,企业需要对此制定应对策略。现在是企业重新审视数据安全的最佳时机,以应对生成式 AI 带来的复杂威胁。生成式 AIGenerative AI,简称 GenAI正迅速改变我们工作方式,它可以生成现实且富有创意的内容,如图像、文本、音频和视频。这项技术的使用场景涵盖企业各个方面,能够提升创造力、提高工作效率,并帮助企业更高效地运转。如今,没有其他技术能够像 AI 一样对我们的工作方式产生如此深远的影响。

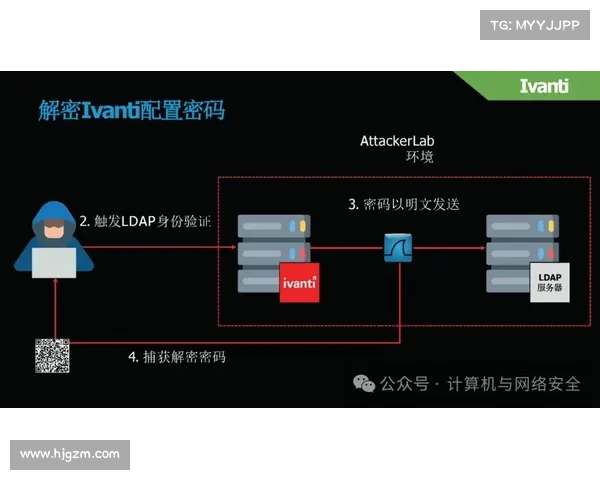

然而,GenAI 也带来了重大的网络安全和数据风险。从用户输入的看似简单的提示中可能包含敏感信息AI 可能会收集和存储这些信息,到生成大规模的恶意软件攻击,生成式 AI 几乎单独扩展了现代企业失去敏感信息的方式。

对于大多数大型语言模型LLM公司而言,他们刚开始将数据安全纳入战略与客户需求中。企业必须调整其安全策略,以适应这一变化,因为 GenAI 的安全风险正显现出多方面的威胁,这是由于用户在组织内部和外部与这些工具的互动造成的。

外网加速npv下载我们目前所知

生成式 AI 系统能收集、存储和处理来自各类来源的大量数据,包括用户的输入。这与当前组织面临的五种主要风险息息相关:

风险类型描述数据泄露员工如果在 GenAI 提示中输入敏感数据,如未发布的财务报表或知识产权,可能导致企业面临与将数据存储在文件共享平台相似的第三方风险。恶意软件攻击GenAI 能生成新的、复杂类型的恶意软件,这些软件可能逃避传统的检测方法,企业将可能面临新的零日攻击潮。如果没有专门的防御机制,IT 团队将很难应对这些威胁。网络钓鱼攻击该技术擅长生成具有欺骗性的假内容,攻击者可以利用这些内容诱使用户泄露敏感信息或进行妥协的操作。随着 GenAI 的普及,企业可能会看到更多的网络钓鱼尝试的增加。偏见问题大型语言模型的回答可能带有偏见,从而提供误导或错误的信息,这源于训练数据中的偏见。不准确性LLM 在分析问题时,可能由于缺乏对情境的全面理解而错误地给出答案。优先考虑数据安全

降低生成式 AI 带来的安全风险,主要围绕三大支柱:员工意识、安全框架和技术手段。

教育员工安全处理敏感信息并非新鲜事。但引入生成式 AI 工具使得必须考虑随之而来的新数据安全威胁。企业首先必须确保员工理解他们可以与 AI 驱动技术分享什么信息,不能分享什么。同时,我们还需提高员工对可能因 GenAI 而增加的恶意软件和网络钓鱼攻击的警惕。

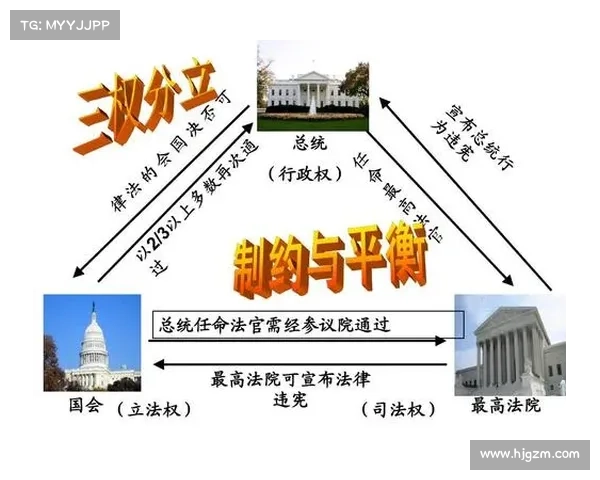

企业运作方式如今比以往任何时候都更加复杂,这也是确保数据安全成为商业迫切需求的原因。数据持续从传统的本地存储转向云环境,人们可以从任何地方访问数据,并努力跟上各种法规要求。

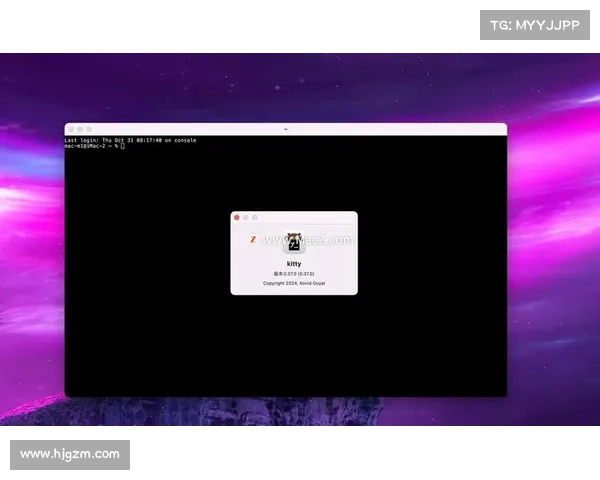

传统的数据丢失防护DLP能力在某些用例中依然强大,但随着数据向云端迁移,DLP 功能也需升级,以扩展覆盖能力。组织现在正在接受云原生 DLP,优先考虑统一的执法,以在重要渠道上扩展数据安全。这一方法简化了合规性,并承诺在数据存储的各处提供行业领先的网络安全。

利用数据安全状态管理DSPM工具也能提供进一步保护。AI 驱动的 DSPM 产品通过快速、准确地识别数据风险,增强数据安全和保护的能力,赋予决策者